Кора

Понятно, что примитивная оптимизация целевой функции, принимающей только два значения: «хорошо» и «плохо», может быть использована лишь на начальной стадии изучения и применения принципов нейросети. В частности, на таких принципах строится модель собачки Павлова, демонстрирующая условный рефлекс при предъявлении этикетки «Pedigree».

Цепочки логических выводов человека содержат не одно, а много звеньев. Сделанные выводы вновь входят в конфигурацию изображений (входных векторов) для новых выводов, действий и т.д.

Буква нужна, чтобы распознать слово; слово — чтобы распознать предложение, уяснить его смысл, предпринять адекватные действия и т.д. Возникает вопрос о целесообразной структуре сети, где выводы, собираясь в различные конфигурации, как бы множась, вновь участвуют в формировании новых выводов. Здесь можно предположить как прямые, так и обратные связи, когда попутно сделанные выводы уточняют умозаключение.

При какой же концентрации выводов совмещаются понятия входного и выходного слоев? Видимо, целесообразно существование универсального слоя — коры, со связями между отдельными нейронами и целыми областями, где сформировавшиеся выводы используются для получения других выводов.

Локализация максимального возбуждения на выходном слое

Проанализировав сказанное выше, попытаемся собрать некоторую универсальную модель нейросети с входным и выходным слоями. Картина возбуждений выходного слоя при подаче изображения на входной слой после аппроксимации в непрерывную область определения из дискретной будет представлять собой непрерывную функцию, максимум которой определяет необходимое заключение. Однако на этапе обучения, а также в рабочем режиме с удовлетворительной достаточно малой вероятностью по ряду предъявляемых эталонов этот максимум не совпадает с нужным ответом. Следовательно, путь распространения возбуждений внутри сети необходимо скорректировать изменением синапсических весов задействованных нейронов.

Как было упомянуто выше, предварительная локализация максимума величины сигнала производится в результате взаимодействия нейронов в области или некоторой окрестности выходного слоя или коры. Области возбуждений «закрепляются» за типами объектов — за буквами, цифрами, продуктами питания и т.д. В развитой сети с актуальным понятием коры нейроны отдельных ее областей через нейроны внутренних слоев вновь порождают пути прохождения возбуждений в другие области коры и т.д.

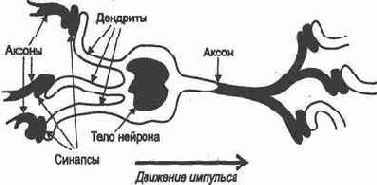

Пытаясь проанализировать и воспроизвести универсальную нейросеть, видим, что отдельный нейрон может взаимодействовать с огромным числом нейронов (нейрон имеет до 10 тыс. дендритов), но это взаимодействие носит локальный характер. А именно, несмотря на случайность связей, вероятность связи с «близким» нейроном значительно выше вероятности связи с нейроном «далеким». Об этом свидетельствуют исследования длины дендритов и аксонов: длина дендрита достигает миллиметра, а длина аксона — сотни миллиметров. При этом применяется, повидимому, усредненная характеристика, вряд ли отражающая нейроны только головного мозга.

Такой принцип локальности, пронизывающий всю структуру сети, в сочетании с принципом иерархии — возможностью построения новых выводов на основе сделанных, позволяет реализовать связи «каждый с каждым». Никакой вывод не остается недоступным и неиспользованным при построении сложных умозаключений.

Принцип локальности обеспечивает минимизацию входной информации, существенное влияние лишь значимых признаков на заключение, контролируемое и диагностируемое пофункциональное разбиение областей нейросети, определение и выделение той области нейросети, в синапсические веса которой необходимо внести поправки в процессе обучения.

Данный принцип не отвергает существования маловероятных связей «каждого с каждым». Эта вероятность может быть высокой вследствие аномалий генетического характера. Например, некий уникум способен «видеть» кожей: нейроны, воспринимающие кожные ощущения, сильно связаны с нейронами выходного слоя, «отвечающими» за зрение. При слабых связях распространение возбуждения от кожных рецепторов в сторону «зрительных» нейронов гаснет. В данном же случае оно становится результативным, поскольку в целом все нейроны устроены одинаково.

Большое число связей способствует высокой надежности мозга. Ведь ежедневная гибель огромного числа нейронов, подхлестнутая алкоголем и наркотиками, а также травмы компенсируются другими путями прохождения возбуждений, иногда даже связанными с Необходимостью переобучения. Впрочем, ограниченный ресурс возможного не спасает в конце концов от деградации.

Рассмотрим теперь более подробно процесс локализации максимальной величины возбуждения на выходном слое, заключающейся в выделении того нейрона некоторой малой области, величина возбуждения которого максимальна. Он основан на подавлении тех сигналов, которые не соответствуют нейрону с максимальным возбуждением т.е. концентрация сигнала и выделение нейрона с максимальной величиной возбуждения достигаются с помощью подавляющих связей «соседних» нейронов выходного слоя.

Пусть нейронам выходного слоя, условно расположенного на плоскости (х,у), соответствует непрерывная функция возбуждения Р(х,у) (рис. 1.7), обусловленная прохождением сигналов возбуждений в сети на основе предъявленного эталона. Будем считать, что эта функция имеет один или более максимум. Пусть

Каждый нейрон (i,j), действуя в своей окрестности, рассылает соседним нейронам, на их дендриты с отрицательными, не обязательно регулируемыми весами первоначальную величину возбуждения

![]() с разными значениями величин возбуждения. Пусть

с разными значениями величин возбуждения. Пусть

Локализация максимального возбуждения на выходном

Рис.1.7. Локализация возбуждения нейронов выходного слоя

При предъявлении на входном слое эталона, т.е. при существовании в некоторый период времени характера и величины возбуждений, обусловливающих возбуждение выходного слоя, между нейронами (i,j) и (i,j+1) происходит перераспределение величины возбуждения. А именно значение

в рамках взаимодействия всех нейронов

Рассматривая этот процесс в рамках взаимодействия всех нейронов области выходного слоя, можно сделать вывод о постепенной концентрации высокого уровня возбуждения, присущего одному или нескольким нейронам и определяющего один или несколько локальных максимумов.

При таком взаимодействии нейронов области возбуждения выходного слоя происходит усиление сигнала наиболее возбужденного нейрона. Полное подавление сигнала возможно только на границе этой области. Если гдето внутри области возбуждение некоторого нейрона окажется подавленным полностью (сигнал не преодолевает порога), то в следующем такте этот нейрон не сможет подавить сигнал того нейрона, который прежде имел более слабый сигнал возбуждения. Тогда возможно появление в указанной области возбуждения нового локального максимума. Таким образом, веса отрицательных связей должны способствовать максимизации возбуждения того нейрона, который первоначально продемонстрировал максимальное возбуждение при затухании возбуждения нейронов в сторону периферии.

Но всегда ли следует на выходном слое локализовать величину возбуждения?

Повидимому, такое усиление возбуждения используется для того, чтобы единственный нейрон выходного слоя преодолел некоторый порог, будучи ответственным за сделанный вывод или решение.

Локализация и максимизация возбуждения на выходном слое особенно важны тогда, когда действительно необходима высокая степень определенности, например в том случае, если получаемый вывод (решение) немедленно участвует в цепочке последующих выводов.

В конце концов все обусловлено назначением сети решаемой задачей. Можно представить себе аттракцион — реакцию фантастического чудовища на изображение, как это показано на рис.

По виду изображения инициируются те или иные программы — радости, гнева, поднятия лап, виляния хвостом и т.д. Возбуждение определенных нейронов выходного слоя связывается с запуском соответствующих программ, где основным параметром является величина возбуждения. Программы не исключают друг друга и могут запускаться в одном такте. При этом предпочтителен запуск только тех программ, значение параметра которых превышает некоторый порог.

В большинстве частных случаев, когда нейросеть обучается с помощью «учителя», т.е. на основе действий извне при ее настройке, присутствует элемент принудительного закрепления нейронов выходного слоя за выводами. В процессе последующего обучения преимущественно с помощью весов синапсических связей добиваются адекватной реакции сети.

Отметим в заключение, что научный аспект проблемы развития и внедрения нейросетевых технологий базируется на философско математическом представлении задач ИИ , выражающемся в формализации процесса мышления.

В работе Д. А. Поспелов, в частности, исследует теорию Аристотеля силлогистику и предлагает принципы ее моделирования. Тем самым указывается важность формализации механизма мышления. Этим механизмом уже давно, со времен Лейбница и до появления булевой алгебры (вплоть до наших дней), является математическая логика, отображенная во многих работах выдающихся математиков.

Математическая логика, ее важный раздел «Алгебра высказываний», действительно соединили принципы мышления и их автоматизированное воплощение.

Однако для реализации мышления природа не создала ничего лучшего, чем человеческий мозг. Он является гигантской нейросетью, фиксирующей причинноследственные связи, создающей базу знаний и владеющей процедурами логического вывода.

Таким образом, нейронные сети реально являются основой формализации средств мышления. Поэтому справедливо считать, что исследование нейронных сетей опирается на достижения математической логики.

Модель мозга

Нейросеть содержит узлы — аналоги нервных клеток — нейронов (нейроподобных элементов, НПЭ) и их соединения — синапсические связи (рис.1.1).

Модель нейрона во взаимодействии с другими нейронами нейросети представлена на рис. 1.2. Здесь

с законом распределения энергии величина

В соответствии с законом распределения энергии величина

Каждый нейрон управляем или извне, или по принципу самоуправления с помощью обратных связей. Можно регулировать значения весов синапсических связей

фрагмент нейросети позволяет представить

Изображенный на рис. 1. 3 фрагмент нейросети позволяет представить следующее:

функции f бывают различны, но просты по объему вычислений. В простейшем случае f совпадает с линейной формой — указанным аргументом, т. е. по всем дендритам с учетом их весов (см. рис. 1.3) производится суммирование и сравнение с порогом:

величина превышения порога является величиной возбуждения нейрона или определяет значение величины возбуждения. Например, в некоторых моделях величина возбуждения всегда равна единице, отсутствие возбуждения соответствует нулю. В других моделях допускают и отрицательную величину возбуждения. Значение возбуждения передается через ветвящийся аксон в соответствии со связями нейрона;

в общем случае по дендритам может передаваться как возбуждающее, так и тормозящее воздействие. Первое может соответствовать положительному значению веса синапсической связи, второе — отрицательному. Аналогичный эффект достигается при передаче отрицательных значений возбуждения нейронов;

в сети распознают входной (рецепторный) слой, воспринимающий внешние возбуждения (на который, например, подается видеоизображение), и выходной спой, определяющий решение задачи. Работа сети тактируется для имитации прохождения по ней возбуждения и управления им;

Установим случайным образом начальные значения

сеть работает в двух режимах:режиме обучения и режиме распознавания (рабочем режиме).

Установим случайным образом начальные значения весов дендритов всей сети. Пусть нейросеть предназначена для распознавания рукописного текста. Тогда входной слой функционирует аналогично сетчатке глаза, которая воспринимает изображение. Его подача на входной слой возбуждает в некоторой конфигурации множество нейронов — рецепторов. Предположим, на входной слой подан и поддерживается некоторый эталон, например буква А. Спустя определенное время максимально возбудится некоторый нейрон выходного слоя (прохождение возбуждения отмечено на рис. 1.3 черным цветом). Закрепим этот нейрон за буквой А, т.е. его возбужденное состояние будем воспринимать как ответ: «Это буква А». Снова введем букву А, но с естественными искажениями, обусловленными почерком, дрожанием руки и т.д.

Возможно максимально возбудится тот же нейрон, а возможно — другой. Мы же хотим «научить» систему, заставить ее ответить, что это тоже буква А, т.е. добиться максимального возбуждения того же нейрона выходного слоя.

Тогда необходимо изменить веса и, возможно, пороги в сети на пути прохождения возбуждения так, чтобы заставить возбудиться нужный нейрон. Такая настройка сети является основным, наиболее важным элементом ее обучением. Применяемые для этого алгоритмы называют алгоритмами обучения.

Одним из наиболее часто применяемых алгоритмов обучения является алгоритм обратного распространения ошибки. В нем воспроизводится подход, используемый в динамическом программировании и основанный на обратном и прямом проходах. Здесь мы предлагаем новый, более простой алгоритм "трассировки", основанный на прямом проходе при прокладывании путей; возбуждения от эталонов к нейронам выходного слоя.

Предъявляя множество эталонов и регулируя параметры, производим обучение сети данному образу. Математические проблемы несовместимости управления параметрами для разных эталонов в данном случае не рассматриваются: в природе такой процесс проходит успешно, достаточно устойчиво при разумном отличии эталонов. Ясно, например, что заставлять один и тот же нейрон выходного слоя возбуждаться и на строчную, и на прописную букву А вряд ли разумно. В лучшем случае он определит, что это вообще буква, а не знак пунктуации.

Обучение заканчивается тогда, когда вероятность «узнавания» достигнет требуемого значения, т.е. необходимость корректировки параметров по предъявляемым эталонам возникает все реже. Теперь можно работать в режиме распознавания. Предъявляем сети различные буквы. Можно быть уверенным, что, если мы предъявим случайно искаженную и даже зашумленную букву А (конечно, в допустимых пределах), сеть ее с большой вероятностью распознает, т. е. максимально возбудится соответствующий нейрон выходного слоя.

Можно существенно облегчить обучение, предъявляя эталон «в полном смысле», т.е., например, показывая букву, регламентированную букварем. Тогда на вероятность распознавания этой буквы будет влиять предусмотренная степень отклонения от данного эталона, обусловленная почерком. Далее необходимо придерживаться именно такого способа обучения.

Расширим функцию входного слоя, связав

Расширим функцию входного слоя, связав его не с изображением, а в общем случае с некоторыми характеристиками исходной ситуации (входного вектора), по которой необходимо принимать решение — формировать выходной вектор. Тогда сеть обучается по эталонным ситуациям, решение которых известно, а затем в рабочем режиме выдает решение во всем диапазоне ситуаций и при этом автоматически определяет, на какую «знакомую» ситуацию более всего похожа введенная и, следовательно, какое решение надо принять.

Такая обработка входной информации при возможном использовании в сфере развлечений показана на рис. 1.4.

Отметим, что нейронная сеть выдает заключение в виде ответа на вопрос: «На какую ситуацию похожа данная и, следовательно, какое должно быть принято решение?» Это еще раз подтверждает, что нейросеть имитирует ассоциативное мышление.

Пространство признаков

Рассмотрим подробнее процесс восприятия, например, строчной буквы а рецепторами — входным слоем нейросети. Конфигурация возбужденных рецепторов, порождая прохождение возбуждения через внутренние слои нейросети (образуя путь возбуждения), задавала возбуждение (не затухшее по пути) одного из нейронов выходного слоя, определяющего: "Это буква а".

Устойчивость подобной схемы по отношению к множеству конфигураций возбуждений рецепторов, соответствующих одной только букве а, вряд ли высока. Такое непосредственное распознавание осуществляется далеко не всегда, ибо наше образование базируется на признаках и определениях (правилах вывода).

Как характеризуется строчная буква а? Это кружок, к которому справа примыкает палочка с хвостиком вправо. А прописная буква "А"? Две палочки с перекладинкой. Но ведь буква Н тоже соответствует этому определению. Тогда следует добавить: прописная "А" — это две палочки, соединенные вверху. (Кстати, соединение вверху может быть изза небрежности лишь обозначено. Тогда о намеке на него можно судить по наклону палочек. Дальнейшая небрежность приведет к неразличимости букв А и Я.)

Значит, существует ряд признаков, лежащих в основе определений. Ясно, что такой способ распознавания гораздо устойчивее к искажениям и особенностям почерка, однозначен и надежен. Ведь при изображении буквы А возможны не только небрежность в верхнем соединении палочек, но и различный наклон буквы, длина боковых палочек, место расположения перекладины, ее наклон, и т.д. Искажение приведет к сомнениям лишь при сходстве с цифрой 4, с телеграфным столбом или с греческой буквой Л. Но даже в этом случае окончательный вывод может быть сделан на основе контекста, т.е. по использованию дополнительных признаков.

Значит, в нашем случае необходимо ввести такие признаки, как наличие кружка, палочек, хвостиков, их взаимного расположения, т.е. построить пространство признаков, преобразовать в это пространство входные изображения, и тогда получим более определенное и устойчивое к искажениям заключение.

Перевод входного изображения в пространство признаков значительно расширяет возможности обзора — масштабирования, размещения, поиска угла наклона, т.е. позволяет с более высокой достоверностью производить распознавание.

Например, изображение танка может в разных ракурсах накладываться на входной слой рецепторов и запоминаться: «и это — танк», «и это — тоже танк» и т.д. Но если ввести определение «танк — это массивный корпус на гусеничном ходу, а сверху — башня с дулом пушки и все такое зелененькое», то в любом случае при распознавании будут приняты меры предосторожности.

Устойчивость и помехозащищенность

В рассмотренном в разд. 1.1 примере относительно жесткого закрепления нейронов выходного слоя между образами принцип ассоциативности или ответ на вопрос: «На что более всего это похоже?», пока не просматривается. Как же он появляется?

Представим себе выходной слой нейросети (рис. 1.5). Рассматривая прохождение возбуждения, например, при подаче того же изображения буквы А, считаем, что в возбужденное состояние придет не один нейрон, строго соответствующий (по нашему желанию) этой букве, — в его окрестности возбудятся и другие нейроны. Причем возбуждение будет угасать по мере удаления. Нам же необходимо, чтобы максимальной величиной возбуждения в этой окрестности обладал именно отмеченный нейрон. Более того, желательно, чтобы эта величина возбуждения была существенно выше величин возбуждения других нейронов. Это обеспечит однозначность при последующем использовании полученного вывода в построении «длинных» логических цепочек для принятия решения. Такая локализация возбуждения позволяет с большой определенностью ответить на вопрос: «На что более всего похож предъявляемый образ, несмотря на случайные отличия его от эталона и помехи?»

Отметим существующую в природе (реализованную в мозге) непрерывность перерастания свойства похожести одних образов в другие. Следование этому принципу при принудительном закреплении нейронов выходного слоя способствует построению адекватных моделей. Говоря точнее, подавая первый раз букву А при случайном начальном выборе весов, не следует указывать системе, какой нейрон выходного слоя должен возбудиться. Лучше подать достаточно «правильный» эталон и посмотреть, какой нейрон возбудится. Этот нейрон и будет впредь соответствовать нашей букве. Возбуждения именно этого нейрона необходимо добиваться при предъявлении других эталонов.

Далее при построении алгоритма обучения предположим, что первоначально сеть «пуста», т.е. все веса синапсических связей равны нулю. Путь возбуждения (связь «посылка — следствие») прокладывается («трассируется») с помощью присваивания некоторым весам положительного значения.

Способы максимизации и локализации уровня возбуждения основаны на нахождении экстремума функции возбуждения, построенной в области выходного слоя. Здесь не обойтись без обмена тормозящими воздействиями между нейронами выходного слоя. Суть идеи в следующем. Все нейроны выходного слоя имеют синапсические связи, такие, что каждый нейрон связан с ближайшими нейронами тормозящими связями, по модулю пропорциональными величине собственного возбуждения. В результате взаимодействия двух нейронов (один из алгоритмов такого взаимодействия будет рассмотрен ниже) более «сильный» сохранит положительный (хотя и меньший) потенциал, сообщив более «слабому» тормозящее воздействие. Такое пошаговое «голосование» на фоне приходящего подтверждения от эталона и выделит сильнейшего.

Итак, мы видим, что обучение сети неразрывно связано с локализацией возбуждения на выходном слое.

В моменты принятия сложных решений

В моменты принятия сложных решений человек старается «заглянуть в себя» и постичь, каким образом он справляется с трудными и порой не решаемыми формальной логикой задачами. Естественное беспокойство и жажда познания обуревают его наряду со смутным сознанием того, что математический, алгоритмический подход к построению сложных кибернетических систем искусственно абсолютизирован. Все должно быть к месту, все должно быть взвешено, И обращаясь к себе, он раз за разом проводит мозговую атаку на то таинственное, созданное природой — на собственный мозг...

Итак, мы вступаем в самую сокровенную область искусственного интеллекта.

Мы смелы и безапелляционны. Долго и систематически насаждаемая духовная нищета заставила нас позабыть о превалирующем духовном начале в человеке. Все больше людей понимают, что мозг — лишь инструмент духа, души. И как любой инструмент, он производится, тупится и приходит в негодность — умирает. Бессмертной остается душа — продукт тонкого мира, мира сверхвысоких частот и, по мнению некоторых философов, настойчиво проявляющейся психической энергии.

А раз мозг — инструмент, его надо тренировать, заполнять, совершенствовать. В природе царит принцип целесообразности, полезности в борьбе за главную установку — установку на развитие. Нужное существует и утверждается, ненужное отмирает, как отмирают неиспользованные, «лишние» нейроны, порождая склеротическую ткань и разъедающую интоксикацию. И человека ленивого, праздного, недеятельного охватывает преждевременное старческое слабоумие. «Душа обязана трудиться», — сказал поэт Н. Заболоцкий. Эту истину мы открываем вновь, с другой, неожиданной стороны...

Мы принимаем сказанное и успокаиваемся. Не вторгаемся мы в то, что для нас сейчас непостижимо, что пока нам не дано. Но кто знает? И на всякий случай мы вооружаемся иронией, преодолевая «сопротивление материала». Ирония позволяет и сказать, и не сказать, предположить, но тотчас, прикрываясь шуткой, трусливо отступить. Только иронией можно защитить себя от мистических страхов, возникающих на трудном пути познания.

Внимание ученых к логическому моделированию процессов головного мозга обусловили следующие причины:

высокая скорость выполнения сложных логических конструкций — предикатов с высоким параллелизмом действий;

простота алгоритмов логических действий мозга, основанная не на численном манипулировании, а на принципах ассоциативного мышления;

возможность решения трудно формализуемых задач, в которых совместно используются данные логически несовместимой природы, противоречивые, неполные, «зашумленные», некорректные;

устойчивость работы, совместимая с расширением, трансформированием и совершенствованием знаний;

надежность, обеспечиваемая наличием многих путей логического вывода и способностью восстановления утраченных данных;

возможность построения самообучающихся и самонастраивающихся систем;

прекрасная сочетаемость с традиционными «вычислительными» алгоритмами обработки информации, позволяющая строить сложные системы управления, с максимальной надежностью, адаптивностью и с минимумом расходуемых ресурсов;

отсутствие требований к «традиционно» развиваемым вычислительным средствам. Единственный стимулируемый принцип — параллелизм. Для реализации параллельной системы — нейросети — необходима параллельная вычислительная система. Ведь для выявления параллелизма, в частности, мы и обращаемся к модели мозга! Наряду с разработкой параллельных вычислительных устройств — нейрокомпьютеров — стимул к развитию получают сети ЭВМ для реализации в них «больших» нейросетей.

и разработчиков сложных управляющих систем

Особый интерес ученых и разработчиков сложных управляющих систем к нейросетевым технологиям, как и к другим технологиям искусственного интеллекта, возник в начале 1980х годов (известный «японский вызов» ), когда остро встала проблема сверхвысокой производительности вычислительных средств.

Приняв этот вызов, многие исследователи обратили внимание на принцип самообучения. Следует отметить краткое, но полное рассмотрение этой проблемы В.В. Игнатущенко .

Благотворное влияние на развитие нейросетевых технологий оказало создание методов параллельной обработки информации .

Необходимо выразить признательность замечательному хирургу, философу и кибернетику Н.М. Амосову , вместе с учениками систематизировавшему подход к созданию средств искусственного интеллекта (ИИ). Этот подход заключается в следующем.

В основе стратегий ИИ лежит понятие парадигмы — взгляда (концептуального представления) на суть проблемы или задачи и принцип ее решения. Рассматривают две парадигмы искусственного интеллекта.

1. Парадигма эксперта предполагает следующие объекты, а также этапы разработки и функционирования системы ИИ:

формализация знаний — преобразование экспертом проблемного знания в форму, предписанную выбранной моделью представления знаний;

формирование базы знаний (БЗ) вложение формализованных знаний в программную систему;

дедукция — решение задачи логического вывода на основе БЗ.

Эта парадигма лежит в основе применения экспертных систем, систем логического вывода, в том числе на языке логического программирования ПРОЛОГ. Считается, что системы на основе этой парадигмы более изучены.

Парадигма ученика, включающая следующие положения и последовательность действий:

обработка наблюдений, изучение опыта частных примеров — формирование базы данных (БД) системы ИИ;

индуктивное обучение — превращение БД в БЗ на основе обобщения знаний, накопленных в БД, и обоснование процедуры извлечения знаний из БЗ. Это означает, что на основе данных делается вывод об общности той зависимости между объектами, которую мы наблюдаем. Основное внимание здесь уделяется изучению аппроксимирующих, вероятностных и логических механизмов получения общих выводов из частных утверждений. Затем мы можем обосновать, например, достаточность процедуры обобщенной интерполяции (экстраполяции), или процедуры ассоциативного поиска, с помощью которой будем удовлетворять запросы к БЗ;

дедукция — по обоснованной или предполагаемой процедуре мы выбираем информацию из БЗ по запросу (например, оптимальную стратегию управления по вектору, характеризующему сложившуюся ситуацию).

Исследования в рамках этой парадигмы и ее разработка проведены пока слабо, хотя они лежат в основе построения самообучающихся систем управления (ниже будет приведен замечательный пример самообучающейся системы управления — правила стрельбы в артиллерии).

Чем база знаний, общий и обязательный элемент системы ИИ, отличается от базы данных? Возможностью логического вывода!

Природа не создала ничего лучшего,

Теперь обратимся к «естественному» интеллекту. Природа не создала ничего лучшего, чем человеческий мозг. Значит, мозг является и носителем базы знаний, и средством логического вывода на ее основе независимо от того, по какой парадигме мы организовали свое мышление, т. е. каким способом заполняем базу знаний, — учимся!

Д.А. Поспелов в замечательной, единственной в своем роде, работе освещает высшие сферы искусственного интеллекта — логику мышления. Цель данной книги — хотя бы частично препарировать нейросеть как средство мышления, тем самым привлекая внимание к низшему, начальному звену всей цепи методов искусственного интеллекта.

Отбросив мистику, мы признаем, что мозг представляет собой нейронную сеть, нейросеть, нейроны, соединенные между собой, со многими входами и единственным выходом каждый. Нейрон реализует достаточно простую передаточную функцию, позволяющую преобразовать возбуждения на входах, с учетом весов входов, в значение возбуждения на выходе нейрона. Функционально законченный фрагмент мозга имеет входной слой нейронов — рецепторов, возбуждаемых извне, и выходной слой, нейроны которого возбуждаются в зависимости от конфигурации и величины возбуждения нейронов входного слоя. Предполагается, что нейросеть, имитирующая работу мозга, обрабатывает не сами данные, а их достоверность, или, в общепринятом смысле, вес, оценку этих данных. Для большинства непрерывных или дискретных данных их задание сводится к указанию вероятности диапазонов, которым принадлежат их значения. Для большого класса дискретных данных — элементов множеств — целесообразно жесткое закрепление нейронов входного слоя.

Распределение величин возбуждения нейронов выходного слоя, а чаще всего нейрон, обладающий максимальной величиной возбуждения, позволяют установить соответствие между комбинацией и величинами возбуждений на входном слое (изображение на сетчатке глаза) и получаемым ответом (что это). Таким образом, эта зависимость и определяет возможность логического вывода вида «если — то». Управление, формирование данной зависимости осуществляются весами синапсических связей нейронов, которые влияют на направления распространения возбуждения нейронов в сети, приводящие на этапе обучения к «нужным» нейронам выходного слоя, т.е. служат связыванию и запоминанию отношений «посылка — следствие». Связь подструктур нейросети позволяет получать «длинные» логические цепочки на основе подобных отношений.

Отсюда следует, что сеть работает в двух режимах: в режиме обучения и в режиме распознавания (рабочем режиме). В режиме обучения производится формирование логических цепочек.

В режиме распознавания нейросеть по предъявляемому образу с высокой достоверностью определяет, к какому типу он относится, какие действия следует предпринять и т.д.

Считается, что в человеческом мозге до 100 млрд нейронов. Но сейчас нас не интересует, как устроен нейрон, в котором насчитывают до 240 химических реакций. Нас интересует, как работает нейрон на логическом уровне, как выполняет он логические функции. Реализация лишь этих функций должна стать основой и средством искусственного интеллекта. Воплощая эти логические функции, мы готовы нарушить основные законы физики, например закон сохранения энергии. Ведь мы рассчитываем не на физическое моделирование, а на доступное, универсальное — компьютерное.

Итак, мы сосредоточиваем внимание на «прямом» использовании нейросетей в задачах искусственного интеллекта. Однако их применение распространяется на решение и других задач. Для этого строят нейросетевые модели со структурой, ориентированной на данную задачу, используют специальную систему связей нейроподобных элементов, определенный вид передаточной функции (часто используют так называемые сигмоидные связи, основанные на участии экспоненты при формировании передаточной функции), специально подобранные и динамически уточняемые веса. При этом используют свойства сходимости величин возбуждения нейронов, самооптимизации. При подаче входного вектора возбуждений через определенное число тактов работы нейросети значения возбуждения нейронов выходного слоя (в некоторых моделях все нейроны входного слоя являются нейронами выходного слоя и других нет) сходятся к неким величинам. Они могут указывать, например, на то, какой эталон в большей степени похож на «зашумленный», недостоверный входной образ, или на то, как найти решение некоторой задачи. Например, известная сеть Хопфилда , хоть и с ограничениями, может решать задачу коммивояжера задачу экспоненциальной сложности. Сеть Хемминга успешно реализует ассоциативную память. Сети Кохонена (карты Кохонена) эффективно используют принцип кластеризации и широко применяются в экономике, финансах, бизнесе и т.д. Эффективно применяются нейросети для аппроксимации функций многих переменных в виде рекурсивного разложения в базисе передаточной функции.

В указанном выше применении нейросети выступают в роли спецпроцессоров для «быстрого» решения частных задач или классов задач. Это можно сравнить с применением аналоговых ЭВМ для решения систем дифференциальных уравнений, где программирование заключается в формировании электрической цепи из элементов заданного набора в соответствии с системой уравнений, а установившийся процесс позволяет на выходе снимать значения функций — решений.

Когда хотят подчеркнуть такие «вычислительные» применения нейросетей, то говорят о нейроподобных задачах, и это не должно отвлекать нас от действий в рамках ИИ, направленных на решение трудно формализуемых задач, на простоту и универсальность, свойственные мозгу.

Ввод и «разглядывание» эталонов и образов

Устройства ввода информации — эталонов, входных векторов, исходных ситуаций — имеют для нейросети определяющее значение. С их помощью формируются и поддерживаются возбуждения входного слоя. Однако связь модели живого организма с внешней средой сложнее. Это настоящий конгломерат ряда частных технических и алгоритмических проблем, к которой относится успешно решаемая проблема видеоввода. Но ввести в компьютер «картинку» — это лишь поддела. «Картинку» надо обработать в целом и по частям, чтобы получить полную и достоверную информацию. В результате имеем аналог нашего восприятия действительности.

Существуют три способа обзора представляемого изображения:

сканирование сектора обзора, разбитого на элементарные сегменты;

сканирование сектора обзора со «своим окном просмотра»;

спонтанный обзор, обусловленный вниманием к цветовому или скоростному всплеску, быстрому увеличению размера (угрожающему приближению) объекта, указанию извне (целеуказанию) и т.д.

Третий способ также основан на сканировании сектора обзора, однако со значительно меньшими энергетическими затратами.

При первом и втором способах анализ сложнее, так как требует согласования виденного по сегментам, что, в свою очередь, приводит к включению высших уровней логического вывода (интеллекта).

Применив третий способ, можно добиться избирательности, чрезвычайности реакции, например, на резкие движения, на бег, на появление яркой расцветки в одежде и т.д., что может с успехом использоваться в игровых системах.

Все способы реализуются легче, если речь идет о единственном объекте единовременного распознавания букве, хозяине квартиры, подписи и т.д. В случае, если существует множество объектов, например туристская группа, любующаяся «умным» монстром, необходим не только детальный, но и совместный анализ этим монстром всех (многих) ее составляющих.

Впрочем, говоря о туристах, можно вести речь о конечной, усредненной реакции монстра на всю группу. Производя обзор, управляющая им нейросеть постепенно согласно критериям обучения «хорошо — плохо» воспринимает настроение как последовательное проявление радости и огорчения и приходит к некоторому окончательному состоянию, обусловленному количественным эквивалентом того и другого. Для разных групп туристов или экскурсантов это состояние будет разным: либо источником веселья и шутливого «поощрения» той группы, которая привела объект в радость, либо источником «осуждения» группы, ввергнувшей его в печаль.

Итак, на каждом такте обзора формируется сегмент, содержимое которого необходимо распознать. Чаще всего целесообразно допущение о том, что в элементарном сегменте (или в «окне просмотра») при дискретном сканировании находится не более чем один значимый объект. Пусть это — максимальная область текста, вмещающая единственную букву, написанную с допустимой долей небрежности. Как разглядеть эту букву? Повидимому, следует разместить ее на входном слое так, чтобы она максимально соответствовала тому размещению эталонов, с помощью которых производилось обучение. Тогда распознавание пойдет корректно (рис. 1.6). Такой процесс «разглядывания» предполагает:

поиск возможности совмещения условного центра элемента изображения и центра экрана — входного рецепторного слоя сети (фокусировку);

поиск варианта масштабирования элемента изображения (приближение — удаление);

поиск угла наклона и др. В результате таких пробных действий может вдруг начаться процесс распознавания, пусть и ошибочного.

в попытке инициировать распознавание сравним

Указанный процесс выделения и размещения в попытке инициировать распознавание сравним с концентрацией внимания и с фокусировкой: ведь зрение в каждый момент времени сконцентрировано на элементе изображения посредством фокусировки на нем глаз в процессе обзора и разглядывания всего изображения.